Una de las quejas más recurrentes que ha habido al uso de generadores de imágenes con inteligencias artificiales como DALL-E o Midjourney, entre otros, ha sido el robo de arte a artistas. Por esta razón, ha surgido una herramienta para proteger sus obras, Nightshade.

Esta herramienta permite a los artistas insertar píxeles indetectables dentro de cada imagen, película u obra, lo que podría alterar los datos de entrenamiento de la inteligencia artificial, según informa el MIT Technology Review.

Ahora, ¿por qué surge esta herramienta? Por ahora, empresas como OpenAI y Meta enfrentan demandas por infracción de derechos de autor y apropiación de obras personales sin compensación a artistas. Esto quiere decir que han detectado un robo de sus creaciones para alimentar a la inteligencia artificial y han tomado acciones legales al respecto.

El equipo detrás de Nightshade sólo busca ser una herramienta preventiva, proteger el arte del robo de estas IA’s. El profesor de la Universidad de Chicago, Ben Zhao, junto con su equipo, desarrolló este modificador, que actualmente se encuentra en proceso de revisión por expertos.

Por ahora, Nightshade ha sido probado en modelos recientes de Stable Diffusion y en una inteligencia artificial construida desde cero por el equipo de Zhao.

¿Cómo funciona Nightshade, la herramienta para proteger a artistas de las IA?

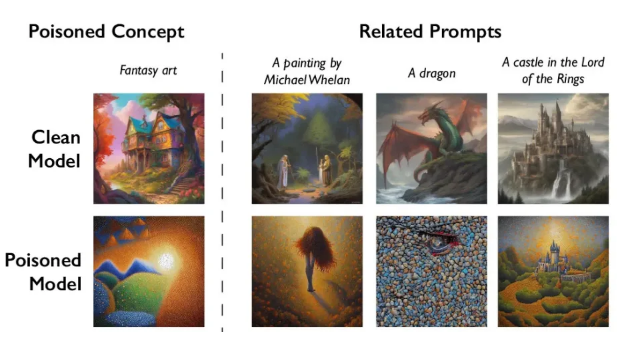

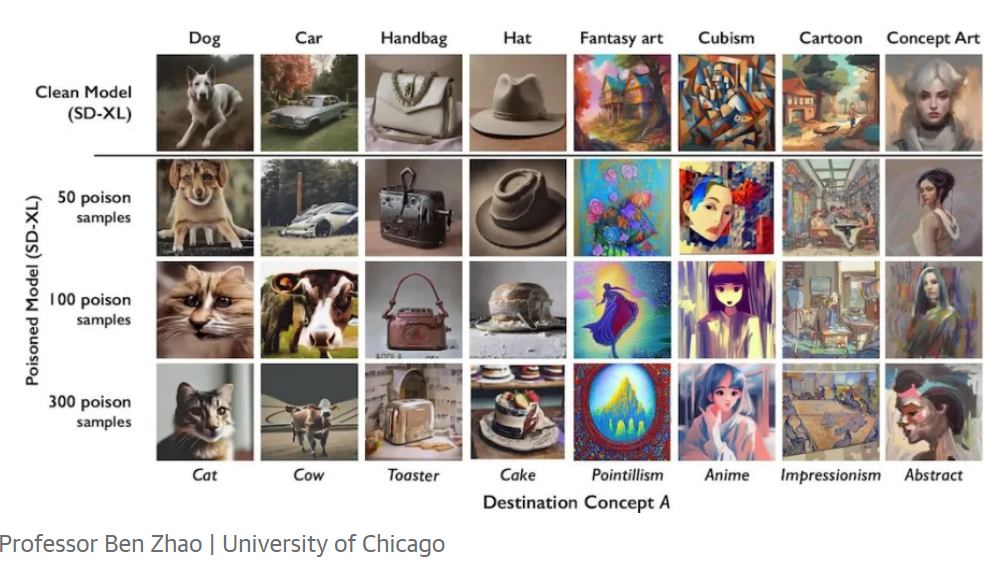

Básicamente, Nightshade funciona como un agente disruptor, modificando la manera en que un modelo de aprendizaje automático genera contenido y transformando el aspecto del producto final. Por ejemplo, podría llevar a una inteligencia artificial a interpretar una solicitud de «bolso» como «tostadora» o mostrar una imagen de un gato en lugar de un perro, lo mismo aplicando a solicitudes similares como «cachorro» o «lobo».

Una serie de ejemplos con contenido alterado ilustra el arte original y cómo podría ser interpretado por una inteligencia artificial:

El profesor Ben Zhao de la Universidad de Chicago y su equipo ya habían lanzado previamente una herramienta llamada Glaze en agosto, la cual también modifica sutilmente los píxeles de una obra de arte, pero de tal manera que los sistemas de inteligencia artificial la identifican como algo completamente diferente a lo que es en realidad. Los artistas que deseen proteger su arte del robo de las IA pueden cargarla en Glaze y optar por utilizar Nightshade.

Tecnologías disruptivas como Nightshade podrían ser un factor determinante para persuadir a las principales empresas de inteligencia artificial a solicitar y compensar adecuadamente el trabajo de los artistas, lo cual parece ser una alternativa más eficaz que tener que reconfigurar todo su sistema. De otro modo, las empresas que busquen eliminar este efecto deberían, probablemente, localizar cada fragmento de datos alterados, una tarea sumamente desafiante.

Recuerda suscribirte a nuestro Newsletter para estar al tanto de más noticias relevantes para ti como esta para saber cómo proteger tu arte de las IA (inteligencias artificiales) como Stable Diffusion, Midjourney, entre otros. Si tienes más dudas de cómo funcionan estas herramientas gratuitas, te recomendamos seguir de cerca nuestras publicaciones.